Acerca del programa

El rol del Data Engineer es esencial en el mundo actual de la analítica avanzada y la inteligencia de datos. En este programa intensivo aprenderás a diseñar, construir y optimizar infraestructuras de datos escalables en la nube con AWS, dominando herramientas líderes como AWS Glue, EMR, Redshift, Kinesis, Apache Spark y Airflow.

A través de una metodología 100% práctica, desarrollarás habilidades para gestionar todo el ciclo de vida del dato: desde la ingestión y el procesamiento, hasta el almacenamiento, la automatización y la orquestación, siempre con foco en gobernanza, seguridad y eficiencia.

⚙️ Aprenderás a construir flujos ETL/ELT por lotes, pipelines en tiempo real y arquitecturas de datos de punta a punta en la nube.

🎯 Al finalizar, estarás listo para asumir roles como Data Engineer, Cloud Data Engineer o Big Data Specialist, aplicando las mejores prácticas del mercado y posicionándote como un profesional altamente competitivo en tecnología y datos.

¿Por qué especializarte en este programa?

Porque los datos ya no son el futuro, son el presente. Y las empresas necesitan profesionales que sepan cómo organizar, transformar y mover datos a escala, utilizando herramientas reales como Amazon Web Services (AWS), Python y bases de datos modernas.

Este programa te lleva paso a paso desde los fundamentos hasta la implementación de flujos de datos profesionales, con una metodología práctica y aplicada.

Si quieres destacar como un perfil técnico de alto valor y con proyección global, especializarte como Data Engineer es una decisión estratégica.

¿Qué ganarías al terminar el programa?

Al terminar este programa, tendrás las habilidades necesarias para diseñar, implementar y automatizar pipelines de datos en la nube con servicios reales de AWS, como S3, Glue, Lambda y Redshift.

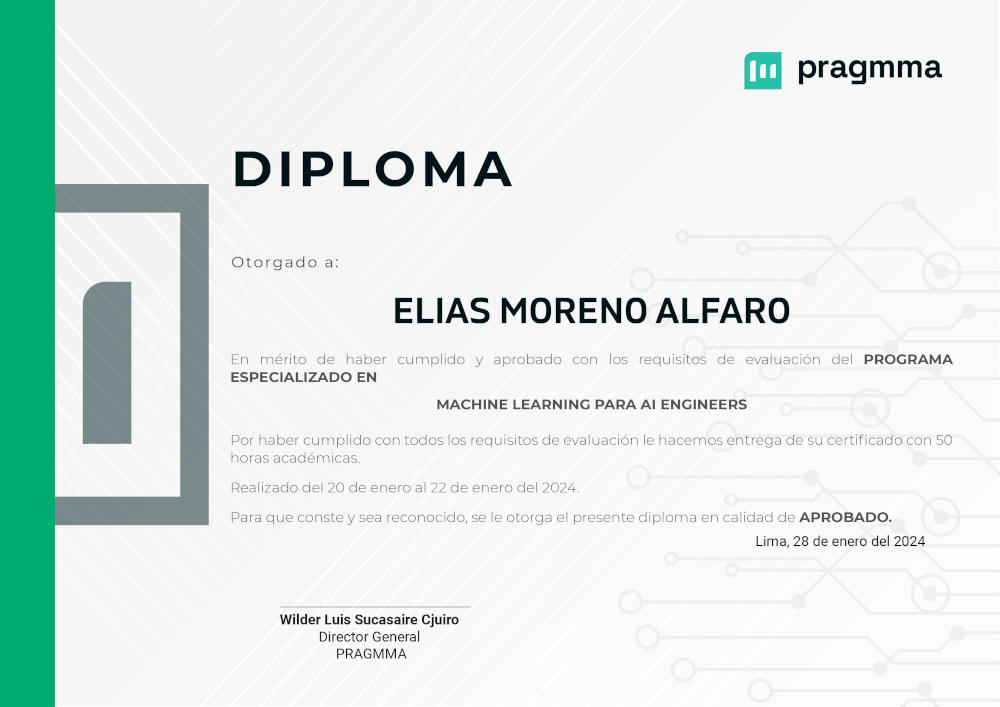

Ganarás una certificación con respaldo institucional, proyectos prácticos aplicables al mundo real y una base sólida para postular a posiciones técnicas de analista o ingeniero de datos en empresas modernas.

Serás un perfil altamente competitivo, con dominio de los entornos más usados por las grandes organizaciones en procesos de análisis y transformación de datos.

Metodología 80/20

- Enfoque 20% teoría / 80% práctica: sesiones dinámicas orientadas a construir soluciones paso a paso, con micro-aprendizajes y actividades aplicadas desde la primera clase. Cada clase dura 150 minutos: máx. 30 min de teoría y 120 min de práctica con ejercicios guiados, datasets y plantillas (ej.: Byte y herramientas afines).

Pre-requisitos

- Dominio de bases de datos (SQL y NoSQL)

- Python o SQL para manipulación de datos

- Conocimientos básicos de Big Data y procesamiento de datos

- Conceptos básicos de procesamiento batch y en tiempo real

- AWS de forma básica (S3, IAM, EC2)

- Importante: El alumno debe contar con una cuenta AWS Free Tier para realizar los laboratorios prácticos.

Aprende como obtener una cuenta AWS Free Tier aquí.